3 随机变量的数字特征

- 理解随机变量的数学期望、方差的概念,并会运用它们的基本性质计算具体分布的期望、方差

- 掌握二项分布、Poisson 分布、均匀分布、指数分布、正态分布的数学期望和方差

- 会根据随机变量的概率分布计算其函数的数学期望

- 理解协方差、相关系数的概念,掌握它们的性质,并会利用这些性质进行计算,了解矩的概念

- 理解大数定理与中心极限定理。

数学期望(均值) 及中位数

数学期望

数学期望也称均值,是随机变量的一个最基本的数字特征. 我们先看如下的一个例子

例 3.1.1. 一甲乙两人赌技相同,各出赌金 100 元,约定先胜三局者为胜,取得全部 200 元。现在甲胜 2 局乙胜 1 局的情况下中止,问赌本该如何分?1

解:如果继续赌下去而不中止,则甲有 3/4 的概率取胜,而乙胜的概率为 1/4.2 所以,在甲胜 2 局乙胜 1 局的这个情况下,甲能期望“得到”的数目,应当确定为

而乙能“期望 " 得到的数目,则为

如果引进一个随机变量 , 等于在上述局面 (甲值 2 胜乙 1 胜) 之下,继续赌下去甲的最终所得,则 有两个可能的值:200 和 0,其概率分别为 3/4 和 1/4. 而甲的期望所得即 的“期望 " 值,即

这就是“数学期望”这个名称的由来. 另一个名称“均值”形象易懂,也很常用.下面我们就给出数学期望(均值)的定义

对一般的离散型分布,我们有

定义 3.1.1. 设 为一离散型随机变量,其分布律为

如果 , 则称

为随机变量 的数学期望 (均值), 用符号 表示

如果 = , 则称 的数学期望 (均值) 不存在

对连续型随机变量,其数学期望的定义如下

定义 3.1.2. 如果连续型随机变量 X 具有密度函数 则当

时,我们将积分

的值称为 X 的数学期望,记作 .如果

则称 的数学期望不存在.

下面求解几种常见分布的数学期望 [[2 随机变量及其分布]]

- 二项分布

- Poisson 分布

- 正态分布

- 均匀分布

- 指数分布

数学期望的性质

- 若干个随机变量线性组合的期望,等于各变量期望的线性组合. 假设 为常数,则有 3

例 3.1.2. 假设随机变量 , 求

解:令 , , 则 且 .所以,

- 若干个独立随机变量之积的期望,等于各变量的期望之积. 即

这里假定各变量相互独立且期望都存在

3.(随机变量函数的期望)设随机变量 为离散型,有分布 = = , = i= , 或者为连续型,有概率密度函数 . 考虑一个函数 g (x)4, 对应的期望为

例 3.1.3. 假设 c 为常数,则

例 3.1.4. 设随机变量 ,求 的数学期望,

解:由 ,正态分布,连续型,使用积分形式,

所以, 5

例 3.1.5. 飞机场载客汽车上有 20 位乘客,离开机场后共有 10 个车站可以下车,若某个车站没有人下车则该车站不停车,设乘客在每个车站下车的可能性相等,以 X 表示停车的次数,求

解:设

则显然 ,6 所以

条件期望

我们知道条件分布也是一个概率分布,因此类似数学期望的定义,我们可以给出条件期望的定义. 在给定了随机变量 取值 的条件之下, 的条件期望,我们记为 ,也可简记为

定义 3.1.3. 设 和 为随机变量,若 为离散型,且在给定 之下, 有分布 , , ,或者 为连续型,且在给定 之下, 的条件密度函数为 , 则

Note

期望所具有的性质, 条件期望同样满足

例 3.1.6. 设 ,试计算

解:由于 , 所以由 [二维正态分布](00 补充知识/二维正态分布) 的性质知

- 没整明白

条件期望 是 的函数,当我们将 换为 时, 就是一个随机变量

定理 3.1.1. 设 为两个随机变量,则有 7

证:我们仅在连续型随机变量的情形下证明此定理. 设 的 p.d.f 为 , 的 p.d.f 为 ,则

推广:当 为可积随机变量时,有

由此得到求解期望的第二种方法:先求解 ,再求解 ,即可求得

例 3.1.7. 一窃贼被关在有 3 个门的地牢里,其中第一个门通向自由.出这门走 3 个小时便可以回到地面;第 2 个门通向另一个地道,走 5 个小时将返回到地牢;第 3 个门通向更长的地道,走 7 个小时也回到地牢,若窃贼每次选择 3 个门的可能性总相同,求他为获得自由而奔走的平均时间。[好题](01 好题/_index)

要求的是时间,设时间为随机变量

解:设这个窃贼需要走 小时才能到达地面,并设 代表他每次对 3 个门的选择情况, 各以 1/3 的概率取值 1,2,3. 则

,而

解得

例 3.1.8. 设 ,试计算

解:先算得

所以

中位数

我们已经知道,随机变量 的数学期望就是它的平均值,因此从一定意义上,数学期望刻画了随机变量所取之值的“中心位置”. 但是,我们也可以用别的数字特征来刻画随机变量的“中心位置”。中位数就是这样一种数字特征

定义 3.1.4. 称 为连续型随机变量 X 的中位数,如果

从定义上可以看出, 这个点把 的分布从概率上一分两半:在 左边占一半, 右边也占一半,从概率上说, 这个点正好居于中央,这就是“中位数”得名的由来. 在实用上,中位数用得很多,特别有不少社会统计资料,常拿中位数来刻化某种量的代表性数值,有时它比数学期望更说明问题,例如,某社区内人的收入的中位数告诉我们:有一半人的收入低于此值,另一半高于此值. 我们直观上感觉到这个值对该社区的收入情况的确很具有代表性,和期望值相比它的一个优点是受个别特别大或特别小的值的影响很小,而期望则不然,举例而言,若该社区中有一个收入在百万元以上,则该社区的均值可能很高,而绝大多数人并不富裕,这个均值并不很有代表性,中位数则不然,它几乎不受少量这种特大值的影响 8

从理论上说,中位数与均值相比还与一个优点,即它总存在,而均值则不是对任何随机变量都存在. 虽则中位数有这些优点,但在概率统计中,无论理论和应用上,数学期望的重要性都超过中位数,其原因有一下两个方面:

-

均值有很多优良的性质,这些性质时使得在数学处理上很方便. 例如, ,而 的中位数与 的中位数之间,不存在这样简单的联系。这使中位数在数学上的处理很复杂且不方便

-

中位数本身固有的某些缺点:中位数可以不唯一,且对于离散型随机变量不易定义

例 3.1.9. 设随机变量 , 求 X 的中位数 [好题](01 好题/_index)

解:由于 X 的分布函数为

由中位数的定义知区间 (0,1) 内的每一个数都是 的中位数,所以此例说明中位数可以不唯一.

方差、标准差和矩

方差和标准差

现在我们转到本章开始时候提到的另一类数字特征,即刻画随机变量在其中心位置附近散布程度的数字特征,其中最重要的是方差.在实际应用中,方差不仅是信息度量的标准也是风险度量的标准

定义 3.2.1. 设 为随机变量,分布为 ,均值为 , (或分布 ) 的方差

定理 3.2.1. 设 c 为常数. 则有

-

因此

-

-

当且仅当 , 其中 , 此时称 X 退化到常数 c.

-

, 其中等号成立当且仅当

-

如果随机变量 和 相互独立, 为常数. 则

常见分布的方差

- 二项分布

- Poisson 分布

- 均匀分布

- 指数分布

- 正态分布

由此得到正态分布 中另一参数 的解释:它就是分布的方差,正态分布完全由其均值 和方差 决定,故也常称为“均值为 方差为 的正态分布 “. 方差 越小,则 的取值以更大的概率集中在其均值 附近

标准化随机变量

定义 3.2.2. 我们称

为 的标准化随机变量. 易见

Note

这里先考虑分子的减法, 仅变动了均值,方差并未改变,再考虑除法,同时改变了均值和方差(由于均值已经变成了 0,所以无影响)

标准化的目的:我们引入标准化随机变量是为了消除由于计量单位的不同而给随机变量带来的影响. 例如,我们考察人的身高,那么当然可以以米为单位,得到 ,也可以以厘米为单位,得到 .于是就有得到 .那么这样一来, 与 的分布就有所不同这当然是一个不合理的现象. 但是通过标准化,就可以消除两者之间的差别,因为我们有 .对于正态分布,我们经过标准化 = ,就可以得出均值为 0 方差为 1 的正态分布,即标准正态分布

矩

下面我们引入矩的概念,并将之与我们前面所说的期望、方差建立联系

定义 3.2.3. 设 为随机变量, 为常数, 为正整数,则 称为 关于 c 点的 阶矩.

比较重要的有两个情况

-

原点矩: .这时 称为 的 阶原点矩

-

中心矩: .这时 称为 的 阶中心矩

容易看出,一阶原点矩就是期望,二阶中心矩就是 的方差

协方差和相关系数(多维随机向量)

现在我们来考虑多维随机向量的数字特征,以二维的情况为例,设 为二维随机变量, 本身都是一维随机变量,那么它们相应的均值方差,我们都在上两节中讨论过了,我们更有兴趣的数字特征是反映分量之间关系的那种量,其中最重要的,是本节要讨论的协方差和相关系数

协方差

定义 3.3.1. 我们称

为 与 的协方差,其中 Cov 是英文单词 Covariance 的缩写.

由协方差的定义,我们立刻可以得到协方差具有如下性质:9

-

-

, 显然若 相互独立,则

-

-

(双线性) 对任何实数 , 有

特别的,

相关系数

定义 3.3.2. 设随机变量 为随机变量,称

为 与 的相关系数. 当 时,则称 与 不相关.

由定义容易看出,若令 = - 和 = - 分别为 和 相应的标准化随机变量,则

因此,形式上可以把相关系数视为“标准尺度下的协方差”,从这个角度上说,相关系数可以更好的反映两个随机变量间的关系,而不受它们各自所用度量单位的影响

例 3.3.1. 设 ,则

相关系数有如下的性质

-

若 和 相互独立,则 (因为此时 )

-

,等号成立当且仅当 之间存在严格的线性关系,即

[注]: 也常称作 和 线性相关系数,只能刻画 和 间的线性相依程度, 越接近 1,就表示 间的线性相关程度越高: 时,只是表示 和 间不存在线性相关,但可以存在非线性的函数关系

例 3.3.2. 设 , ,均值为 0, 而 ,则

所以 不相关. 但是 之间存在着非线性的函数关系。

不相关与独立性之间的关系

定理 3.3.1. 对随机变量

-

独立一定不相关

-

不相关无法判断独立性

例 3.3.3. 试证明若 服从单位圆内的均匀分布,则 不相关但不独立

解:由 服从单位圆内的均匀分布,则 的联合密度函数

由此,可得 和 的边缘密度函数为

因此, ,又

所以, , 从而 , 即 和 不相关. 但由 , 知 X 和 Y 显然不独立

例 3.3.4. 设随机变量 和 的分布律分别为

并且 . (这里是题目条件)

则 与 不独立,也不相关

[注]:只在正态情形下,不相关与独立等价. 我们举二维正态的例子来说明,不妨设 ,则 和 独立等价于 ,从而等价于 和 不相关

其他一些数字特征与相关函数

- 平均绝对差

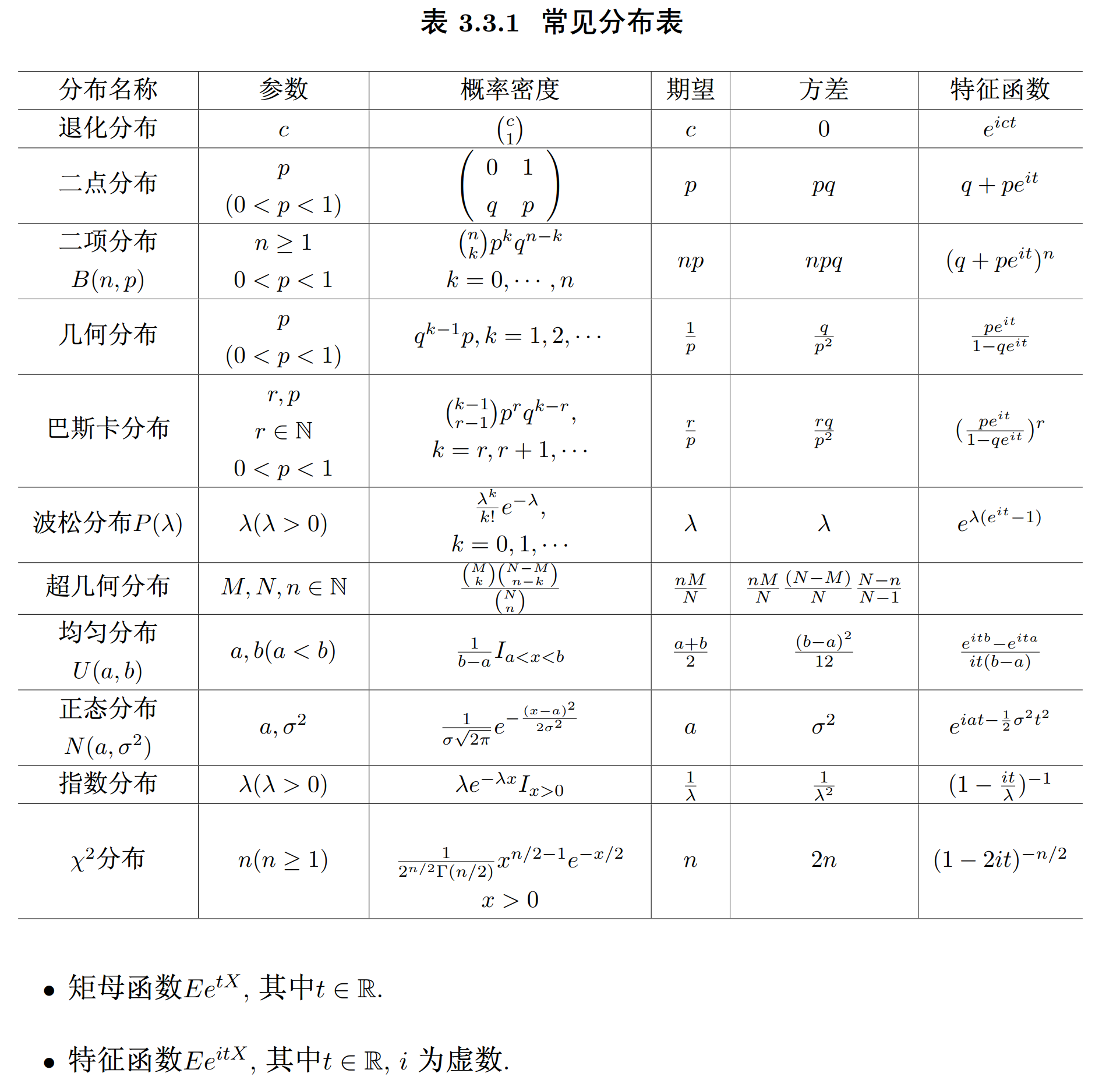

表 3.3.1 常见分布表

疑似复分布问题 - 总之先了解

定义 3.4.1. 如果离散型随机变量 的分布律为 , , ,那么

如果连续型随机变量 X 的密度函数为 ,那么

大数定律和中心极限定理

极限定理是概率论的重要内容,也是数理统计学的基石之一. 中心极限定理,是概率论中讨论随机变量和的分布以正态分布为极限的一组定理这组定理是数理统计学和误差分析的理论基础,指出了大量随机变量近似服从正态分布的条件

大数定律

定义 3.5.1. 如果对任何 ,都有

那么我们就称随机变量序列 , 依概率收敛到随机变量 ,记为

定理 3.5.1. 设 是一列独立同分布 的随机变量序列 10,具有公共的数学期望 和方差 :则

即 服从 (弱) 大数定律。

[注]:实际上,我们只需要均值存在即有大数定律成立,上述定理中加上了方差存在的条件,只是为了证明的方便。

补充

作为上述定理的一个特例,我们有

例 3.5.1. 如果以 表示 重 Bernoulli 试验中的成功次数,则有

如果用 表示成功出现的频率,则上例说明 即频率(依概率)收敛到概率.

为证明定理 3.5.1. 我们需要如下的 Chebyshev 不等式

引理 3.5.1(Chebyshev 不等式). 设随机变量 的方差存在,则

Note

我们可以用 Chebyshev 不等式来估计 与 的偏差,但是 Chebyshev 不等式作为一个理论工具比作为估计的实际方法要恰当一些,其重要性在于它的应用普遍性,但是不能希望很普通的命题对一些个别情况给了深刻的结果. 如令 为掷一个均匀的般子所得到的点数, 则 , Var . 与 的最大偏差为 大于这个偏差的概率为 0. 然而利用 Chebyshev 不等式仅仅断定这个概率少于 0.47. 这时就需要找更精确的估计.

定理 3.5.1 的证明. 利用 Chebyshev 不等式,并注意到 , Var 我们有,

定理得证

中心极限定理

中心极限定理是概率论中讨论随机变量序列的分布收敛于正态分布的一类定理. 它是概率论中最重要的一类定理,有广泛的实际应用背景. 在自然界与生产中,一些随机现象可能会受到许多不确定因素的影响,如果这些彼此之间没有什么依存关系,且谁也没有特别突出的影响,那么这些影响的累积效应将会使现象近似地服从正态分布. 中心极限定理就是从数学上证明了这一现象

定理 3.5.2. 设 为 i.i.d 的随机变量序列,具有公共的数学期望 和方差 ,则 的标准化形式 11 满足中心极限定理. 即对任意 ,有

其中 为 的分布函数,而 为标准正态分布 的分布函数. 记为

定理 3.5.2 的令人吃惊之处就是任何独立同分布的随机变量序列,不论它的分布是什么. 只要存在有限的方差那么它们的标准化部分和都渐近于标准正态分布这也说明了正态分布的普遍性

由定理 3.5.2. 我们很容易得到如下推论

定理 3.5.3. 设 相互独立且具有相同的分布

则有

即

定理 3.5.2 称为棣募弗 - 拉普拉斯定理. 是历史上最早的中心极限定理. 因为定理 3.5.2 中随机变量 的和 ,我们利用正态分布近似地估计二项分布.

- 这里没看懂

设 是两个正整数,则当 相当大时,由定理 3.5.2. 近似地有

其中

为提高精度,我们可把 修正为

例 3.5.2. 设一考生参加 100 道题的英语标准化考试(每道题均为有四个备选答案的选择题,有且仅有一个答案是正确的),每道题他都随机地选择一个答案,假设评分标准为: 选对得一分,选错或不选不得分。试给出该考生最终得分大于等于 25 的概率

解:记 表示第题的得分, = 1,2 ,100 则 是一列独立同分布的随机变量具有共同的分布

利用中心极限定理有

例 3.5.3. 每天有 1000 个旅客需要乘坐火车从芝加哥到洛杉矶,这两个城市之间有两条竞争的铁路,它们的火车同时开出同时到达并且具有同样的设备. 设这 1000 个人乘坐那一条铁路的火车是相互独立而且又是任意的,于是每列火车的乘客数目可视为概率为 1/2 的 1000 重 Bernoulli 试验中成功的次数. 如果一列火车设置 个座位,那么一旦有多于 个旅客来乘车就容纳不下了,令这个事件发生的概率为 利用中心极限定理,有

要求 s 使得 即在 100 次中有 99 次是有足够的座位的. 查表容易求出 这样,两列火车所有的座位数为 1074, 其中只有 74 个空位,可见由于竞争而带来的损失是很小的.

[[4 数理统计的基本概念及抽样分布]]

-

hrj: 实际上是求最后获得的期望,但我有个疑问,两方期望的和一定自洽吗? ↩︎

-

hrj: 这里要考虑后面可能的局数噢 ↩︎

-

这里的 是两个随机量, 不是同一随机量的不同取值,后者通常用小写字母表示 ↩︎

-

这里 g (x) 需满足什么条件书上没提, 暂且理解为 " 常规 " 形式吧 ↩︎

-

这里的 是指示变量,就是表示随机变量 X 的每种可能,=1 就是发生,=0 就是不发生,同样满足之前的线性规则,即 ↩︎

-

仅大致看懂,还不会用 ↩︎

-

与均值相比,中位数常常反应的是大多数的位置 ↩︎

-

这些证明写写就挺显然的,因为 E 本身就是线性运算 ↩︎

-

也就是从 的序列,其中每一个都是独立的随机变量 ↩︎

-

标准化随机变量 ↩︎